Cette semaine, c'est Google Cloud Next à Las Vegas, ce qui signifie l'arrivée d'une série de nouveaux types d'instances et d'accélérateurs sur la plateforme Google Cloud. En plus des nouveaux processeurs personnalisés Axion basés sur Arm, la plupart des annonces de cette année concernent des accélérateurs d'IA, que ce soit ceux développés par Google ou par Nvidia.

Il y a seulement quelques semaines, Nvidia a annoncé sa plateforme Blackwell. Cependant, ne vous attendez pas à ce que Google propose ces machines de sitôt. Le support pour les puissants Nvidia HGX B200 pour les charges de travail en IA et HPC et les GB200 NBL72 pour l'entraînement de grands modèles de langue (LLM) sera disponible début 2025. Une information intéressante de l'annonce de Google : les serveurs GB200 seront refroidis par liquide.

Cela peut sembler être une annonce prématurée, mais Nvidia a affirmé que ses puces Blackwell ne seront pas disponibles publiquement avant le dernier trimestre de cette année.

Avant Blackwell

Pour les développeurs ayant besoin de plus de puissance pour entraîner des LLM aujourd'hui, Google a également annoncé l'instance A3 Mega. Cette instance, développée par l'entreprise en collaboration avec Nvidia, est dotée des GPU H100 standard de l'industrie mais les associe à un nouveau système de réseau capable de fournir jusqu'à deux fois la bande passante par GPU.

Une autre nouvelle instance A3 est A3 confidential, que Google présente comme permettant aux clients de « mieux protéger la confidentialité et l'intégrité des données sensibles et des charges de travail en IA pendant l'entraînement et l'inférence ». L'entreprise propose depuis longtemps des services de calcul confidentiel qui chiffrent les données en cours d'utilisation, et ici, une fois activé, le calcul confidentiel chiffrera les transferts de données entre le CPU d'Intel et le GPU Nvidia H100 via PCIe protégé. Aucun changement de code n'est nécessaire, selon Google.

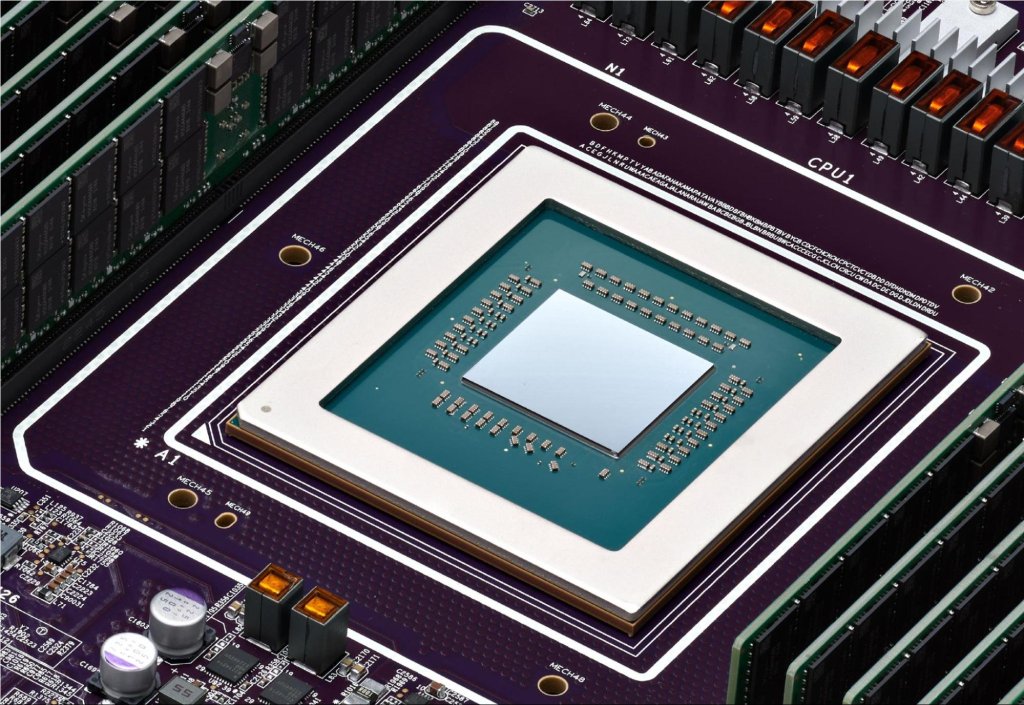

En ce qui concerne les puces de Google, l'entreprise a lancé mardi ses processeurs Cloud TPU v5p — les accélérateurs IA maison les plus puissants à ce jour — en disponibilité générale. Ces puces offrent une amélioration de 2x en opérations en virgule flottante par seconde et une amélioration de 3x en vitesse de bande passante mémoire.

Toutes ces puces rapides nécessitent une architecture sous-jacente capable de les suivre. En plus des nouvelles puces, Google a également annoncé mardi de nouvelles options de stockage optimisées pour l'IA. Hyperdisk ML, qui est maintenant en prévisualisation, est le service de stockage de blocs de nouvelle génération de l'entreprise capable d'améliorer les temps de chargement des modèles jusqu'à 3,7 fois, selon Google.

Google Cloud lance également plusieurs instances plus traditionnelles, alimentées par les processeurs Xeon de quatrième et cinquième génération d'Intel. Les nouvelles instances polyvalentes C4 et N4, par exemple, seront dotées des Xeons Emerald Rapids de cinquième génération, le C4 étant axé sur les performances et le N4 sur le prix. Les nouvelles instances C4 sont maintenant en prévisualisation privée, et les machines N4 sont désormais disponibles.

Également nouvelles, mais encore en prévisualisation, sont les machines bare-metal C3, alimentées par les anciens Xeons de quatrième génération d'Intel, les instances bare-metal optimisées pour la mémoire X4 (également en prévisualisation) et le Z3, première machine virtuelle de Google Cloud optimisée pour le stockage qui promet d'offrir « le plus grand IOPS pour des instances optimisées pour le stockage parmi les principaux fournisseurs de cloud ».

Le discours d'ouverture de Nvidia lors de la GTC a réservé des surprises