L'Inde, experte en matière d'utilisation de la technologie pour persuader le public, est devenue un point chaud mondial en ce qui concerne l'utilisation, et l'abus, de l'IA dans le discours politique, et plus spécifiquement dans le processus démocratique. Les entreprises technologiques, qui ont inventé les outils en premier lieu, se rendent dans le pays pour promouvoir des solutions.

Plus tôt cette année, Andy Parsons, directeur principal chez Adobe chargé de sa participation à l'Initiative d'authenticité du contenu intersectorielle (CAI), s'est retrouvé au cœur de l'action lorsqu'il s'est rendu en Inde pour rencontrer des médias et des organisations technologiques dans le pays afin de promouvoir des outils pouvant être intégrés aux flux de travail des contenus pour identifier et signaler le contenu généré par l'IA.

« Au lieu de détecter ce qui est faux ou manipulé, nous, en tant que société, et c'est une préoccupation internationale, devrions commencer à déclarer l'authenticité, c'est-à-dire dire si quelque chose est généré par l'IA cela devrait être connu des consommateurs », a-t-il déclaré dans une interview.

Parsons a ajouté que certaines entreprises indiennes − actuellement non parties à un accord de sécurité électorale de l'IA à Munich signé par OpenAI, Adobe, Google et Amazon en février − avaient l'intention de créer une alliance similaire dans le pays.

« La législation est une chose très délicate. Supposer que le gouvernement légiférera correctement et assez rapidement dans n'importe quel territoire est quelque chose sur lequel il est difficile de compter. Il est préférable que le gouvernement adopte une approche très prudente et prenne son temps », a-t-il déclaré.

Les outils de détection sont célèbres pour leur manque de consistance, mais ils sont un début pour résoudre certains des problèmes, du moins c'est l'argument avancé.

« Le concept est déjà bien compris », a-t-il déclaré lors de son voyage à Delhi. « Je contribue à sensibiliser aux outils qui sont également prêts. Ce n'est pas juste une idée. C'est quelque chose qui est déjà déployé. »

La CAI, qui promeut des normes ouvertes et libres de droits pour identifier si un contenu numérique a été généré par une machine ou par un humain, existe depuis avant l'engouement actuel autour de l'IA générative : elle a été fondée en 2019 et compte désormais 2 500 membres, dont Microsoft, Meta et Google, The New York Times, The Wall Street Journal et la BBC.

De même qu'une industrie se développe autour de l'utilisation de l'IA pour créer des médias, une autre, plus petite, est en train de se créer pour tenter de corriger certaines des applications les plus néfastes de celle-ci.

Ainsi, en février 2021, Adobe a franchi une étape supplémentaire en construisant l'une de ces normes elle-même et a co-fondé la Coalition pour la provenance et l'authenticité du contenu (C2PA) avec ARM, la BBC, Intel, Microsoft et Truepic. La coalition vise à développer une norme ouverte, qui exploite les métadonnées des images, vidéos, textes et autres médias pour mettre en valeur leur provenance et informer les gens sur l'origine du fichier, l'emplacement et l'heure de sa génération, et s'il a été modifié avant d'arriver à l'utilisateur. La CAI collabore avec la C2PA pour promouvoir la norme et la rendre accessible au grand public.

Elle s'implique maintenant activement avec des gouvernements comme celui de l'Inde pour élargir l'adoption de cette norme afin de mettre en évidence la provenance du contenu généré par l'IA et de collaborer avec les autorités à l'élaboration de directives pour le développement de l'IA. Adobe n'a rien à perdre, mais aussi tout à perdre en jouant un rôle actif dans ce jeu. Elle n'acquiert pas encore ni ne construit de grands modèles de langage (LLM) en propre, mais en tant que foyer d'applications comme Photoshop et Lightroom, elle est le leader du marché des outils pour la communauté créative, et donc elle ne se contente pas de développer de nouveaux produits comme Firefly pour générer du contenu IA nativement, mais elle infuse également des produits hérités avec de l'IA. Si le marché se développe comme certains le croient, l'IA deviendra un élément indispensable dans le mix si Adobe veut rester en tête. Si les régulateurs (ou le bon sens) ont leur mot à dire, l'avenir d'Adobe dépendra vraisemblablement de sa capacité à s'assurer que ce qu'elle vend ne contribue pas au désordre.

Le tableau général en Inde est de toute façon un désordre.

Google s'est concentré sur l'Inde comme banc d'essai pour interdire l'utilisation de son outil d'IA générative Gemini en ce qui concerne le contenu électoral ; les partis utilisent l'IA pour créer des mèmes avec des ressemblances d'adversaires ; Meta a mis en place une « helpline » deepfake pour WhatsApp, tel est le succès de la plateforme de messagerie dans la diffusion de missives alimentées par l'IA ; et à un moment où les pays se montrent de plus en plus alarmés par la sécurité de l'IA et ce qu'ils doivent faire pour s'assurer de celle-ci, nous verrons quel impact aura la décision du gouvernement indien en mars de relâcher les règles sur la façon dont les nouveaux modèles d'IA sont construits, testés et déployés. Cela devrait certainement encourager davantage d'activité en matière d'IA.

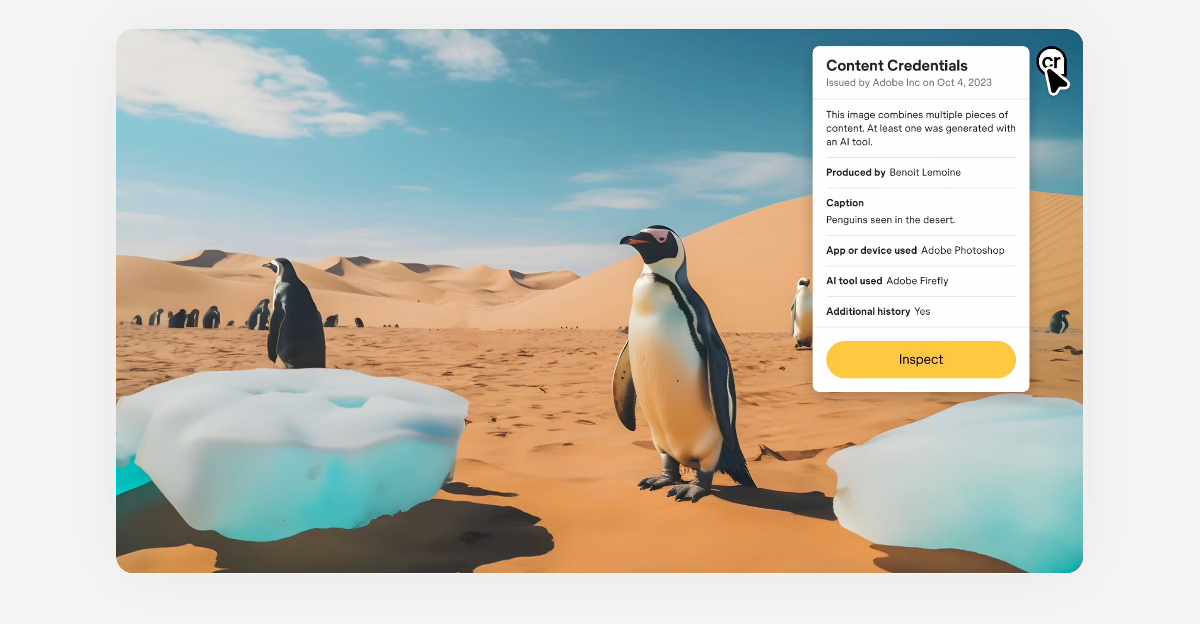

Grâce à sa norme ouverte, la C2PA a développé une étiquette de nutrition numérique pour le contenu appelée Content Credentials. Les membres de la CAI travaillent pour déployer le filigrane numérique sur leur contenu pour informer les utilisateurs de son origine et de savoir s'il a été généré par l'IA. Adobe a des Content Credentials dans l'ensemble de ses outils créatifs, y compris Photoshop et Lightroom. Il est également automatiquement attaché au contenu IA généré par le modèle IA Firefly d'Adobe. L'année dernière, Leica a lancé son appareil photo avec des Content Credentials intégrés, et Microsoft a ajouté des Content Credentials à toutes les images générées par l'IA créées à l'aide de Bing Image Creator.

Parsons a déclaré à TechCrunch que la CAI discute avec les gouvernements du monde entier sur deux points : l'un est d'aider à promouvoir la norme en tant que norme internationale, et l'autre est de l'adopter.

« En année électorale, il est particulièrement critique pour les candidats, les partis, les bureaux en exercice et les administrations qui diffusent constamment du matériel aux médias et au public de s'assurer qu'il est possible de savoir que si quelque chose provient du bureau du PM [Narendra] Modi, cela provient effectivement du bureau du PM Modi. Il y a eu de nombreux incidents où ce n'était pas le cas. Ainsi, comprendre qu'un contenu est vraiment authentique pour les consommateurs, les vérificateurs de faits, les plateformes et les intermédiaires est très important », a-t-il déclaré.

La grande population, la vaste diversité linguistique et démographique de l'Inde rendent difficile la lutte contre la désinformation, a-t-il ajouté, plaidant en faveur de simples étiquettes pour couper à travers cela.

« C'est un peu 'CR'... Ce sont deux lettres occidentales comme la plupart des outils Adobe, mais cela indique qu'il y a plus de contexte à montrer », a-t-il dit.

La controverse continue de tourner autour de ce que pourrait être le véritable objectif des entreprises technologiques en soutenant toute mesure de sécurité de l'IA : s'agit-il vraiment d'une préoccupation existentielle, ou simplement d'avoir une place à la table pour donner l'impression d'une préoccupation existentielle, tout en veillant à ce que leurs intérêts soient protégés dans le processus d'élaboration des règles ?

« Ce n'est généralement pas controversé pour les entreprises qui y sont impliquées, et toutes les entreprises qui ont signé l'accord récent de Munich, y compris Adobe, qui se sont réunies, ont mis de côté les pressions concurrentielles car ces idées sont quelque chose que nous devons tous mettre en œuvre », a-t-il déclaré en défense du travail.