Google n'a pas le meilleur historique en matière d'intelligence artificielle génératrice d'images.

En février, le générateur d'images intégré à Gemini, le chatbot alimenté par l'IA de Google, a été découvert injectant aléatoirement de la diversité de genre et raciale dans des suggestions sur les personnes, ce qui a entraîné des images de nazis d'origines diverses, parmi d'autres inexactitudes offensantes.

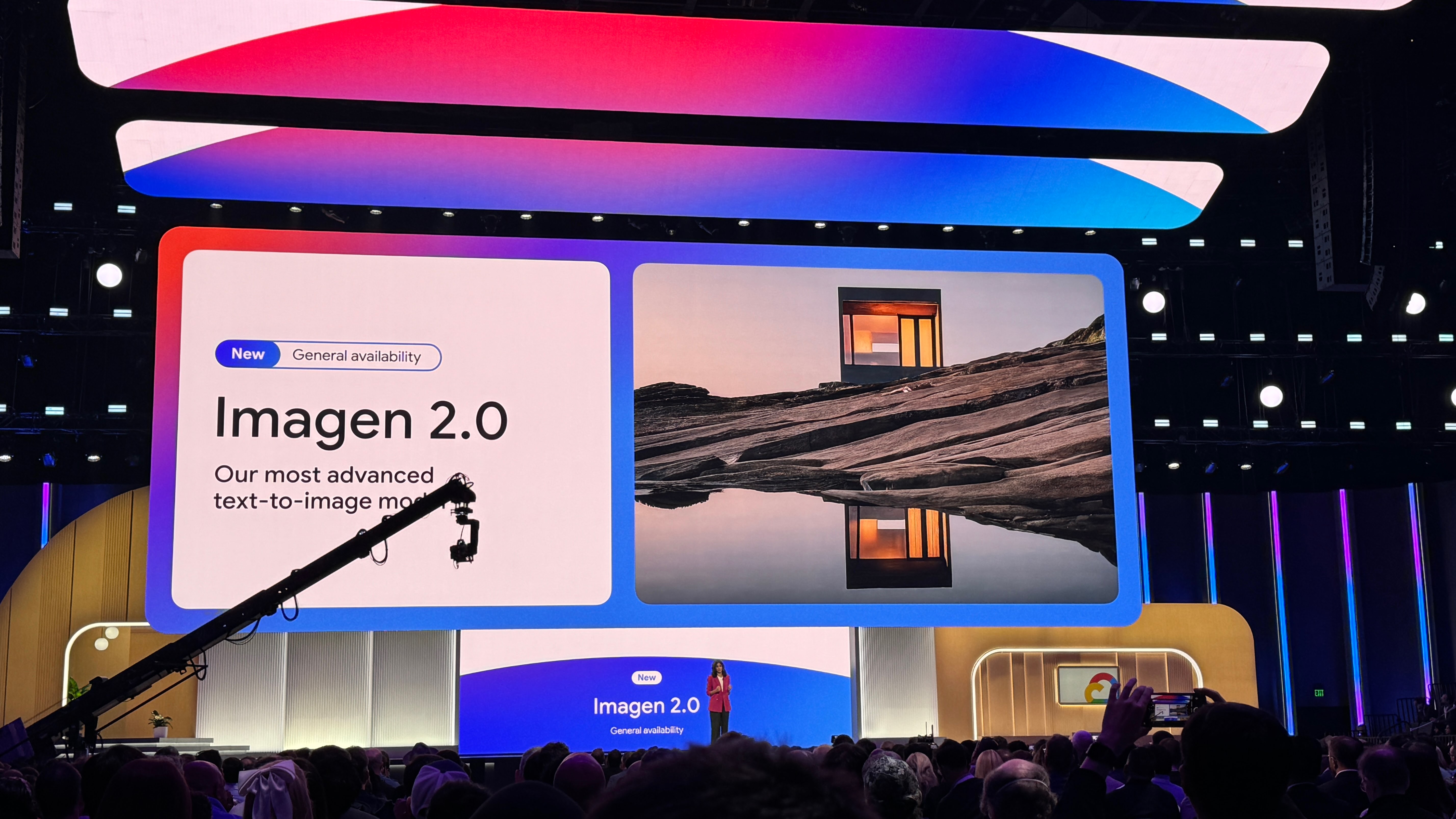

Google a retiré le générateur, promettant de l'améliorer et de le réintroduire ultérieurement. En attendant son retour, la société lance un outil de génération d'images amélioré, Imagen 2, à l'intérieur de sa plateforme de développement Vertex AI - bien qu'un outil avec une orientation clairement plus orientée entreprise.

Imagen 2 - qui est en fait une famille de modèles, lancée en décembre après avoir été prévisualisée lors de la conférence I/O de Google en mai 2023 - peut créer et éditer des images à partir d'une suggestion de texte, comme DALL-E et Midjourney d'OpenAI. D'intérêt pour les professionnels, Imagen 2 peut rendre du texte, des emblèmes et des logos dans plusieurs langues, superposant éventuellement ces éléments sur des images existantes - par exemple, sur des cartes de visite, des vêtements et des produits.

Google dévoile Imagen 2 avec génération de texte et de logo

Après avoir été lancée en prévisualisation, l'édition d'images avec Imagen 2 est désormais disponible dans Vertex AI, avec deux nouvelles fonctionnalités: l'inpainting et l'outpainting. L'inpainting et l'outpainting, des fonctionnalités proposées depuis un certain temps par d'autres générateurs d'images populaires comme DALL-E, peuvent être utilisées pour supprimer des parties indésirables d'une image, ajouter de nouveaux éléments et agrandir les bordures d'une image pour créer un champ de vision plus large.

Mais le vrai point fort de la mise à niveau d'Imagen 2 est ce que Google appelle les “images en direct à partir de texte”.

Imagen 2 peut désormais créer de courtes vidéos de quatre secondes à partir de suggestions de texte, dans la lignée d'outils de génération de clips alimentés par l'IA comme Runway, Pika et Irreverent Labs. Fidèle à l'orientation d'Imagen 2 vers les entreprises, Google présente les images en direct comme un outil pour les spécialistes du marketing et les créatifs, comme un générateur de GIF pour des publicités montrant la nature, la nourriture et les animaux - des sujets sur lesquels Imagen 2 a été peaufiné.

Google indique que les images en direct peuvent capturer “une série d'angles de caméra et de mouvements”, tout en “assurant la cohérence sur l'ensemble de la séquence.” Mais elles sont actuellement en basse résolution: 360 pixels par 640 pixels. Google promet que cela s'améliorera à l'avenir.

Pour apaiser (ou du moins tenter d'apaiser) les préoccupations concernant la création de deepfakes, Google indique qu'Imagen 2 utilisera SynthID, une approche développée par Google DeepMind, pour appliquer des filigranes cryptographiques invisibles aux images en direct. Bien sûr, détecter ces filigranes - que Google affirme être résistants aux modifications, y compris la compression, les filtres et les ajustements de tons de couleur - nécessite un outil fourni par Google qui n'est pas disponible pour les tiers.

Et sans aucun doute désireux d'éviter une autre controverse sur les médias génératifs, Google met l'accent sur le fait que les générations d'images en direct seront “filtrées pour la sécurité.” Un porte-parole a déclaré à TechCrunch par e-mail: “Le modèle Imagen 2 dans Vertex AI n'a pas rencontré les mêmes problèmes que l'application Gemini. Nous continuons à tester de manière approfondie et à collaborer avec nos clients.”

Mais en supposant généreusement un instant que la technologie de filigrane de Google, les atténuations de biais et les filtres sont aussi efficaces qu'elle le prétend, les images en direct sont-elles même compétitives avec les outils de génération vidéo déjà existants?

Pas vraiment.

Runway peut générer des clips de 18 secondes en résolutions beaucoup plus élevées. L'outil de clip vidéo de Stability AI, Stable Video Diffusion, offre une plus grande personnalisabilité (en termes de fréquence d'images). Et Sora d'OpenAI - qui, il est vrai, n'est pas encore disponibles commercialement - semble être prêt à surpasser la concurrence avec le photoréalisme qu'il peut atteindre.

Quels sont donc les véritables avantages techniques des images en direct? Je ne suis pas vraiment sûr. Et je ne pense pas être trop sévère.

Après tout, Google est derrière des technologies de génération de vidéo vraiment impressionnantes comme Imagen Video et Phenaki. Phenaki, l'une des expériences les plus intéressantes de Google en matière de texte en vidéo, transforme des suggestions longues et détaillées en “films” de plus de deux minutes - avec la réserve que les clips sont en basse résolution, à faible taux d'images et seulement quelque peu cohérents.

À la lumière de rapports récents suggérant que la révolution de l'IA générative a pris de court le PDG de Google, Sundar Pichai, et que la société peine encore à suivre le rythme de ses concurrents, il n'est pas surprenant qu'un produit comme les images en direct semble être un suiveur. Mais c'est néanmoins décevant. J'ai l'impression qu'un produit plus impressionnant se cachait (ou se cache encore) dans les laboratoires secrets de Google.

Les modèles comme Imagen sont formés sur un nombre énorme d'exemples généralement issus de sites publics et de jeux de données sur le web. De nombreux fournisseurs d'IA générative voient les données d'entraînement comme un avantage concurrentiel et les gardent donc proches, ainsi que les informations les concernant. Mais les détails des données d'entraînement sont également une source potentielle de poursuites en matière de PI, un autre désincitatif à révéler beaucoup de choses.

J'ai demandé, comme je le fais toujours autour des annonces concernant les modèles d'IA générative, quelles données ont été utilisées pour entraîner l'Imagen 2 mise à jour, et si les créateurs dont le travail pourrait avoir été intégré dans le processus d'entraînement du modèle pourront se retirer à un moment donné à l'avenir.

Google m'a simplement dit que ses modèles sont formés “principalement” sur des données web publiques, tirées de “publications de blog, de transcriptions médiatiques et de forums de discussion publics.” Quels blogs, transcriptions et forums? C'est une devinette.

Un porte-parole a souligné les contrôles des éditeurs web de Google qui permettent aux webmasters d'empêcher la société de collecter des données, y compris des photos et des œuvres d'art, depuis leurs sites web. Mais Google n'a pas pris l'engagement de publier un outil d'opt-out ou, en alternative, de compenser les créateurs pour leurs contributions (sans le vouloir) - une étape que beaucoup de ses concurrents, y compris OpenAI, Stability AI et Adobe, ont prise.

Un autre point à mentionner : les images en direct à partir de texte ne sont pas couvertes par la politique d'indemnisation de l'IA générative de Google, qui protège les clients de Vertex AI des réclamations liées au droit d'auteur concernant l'utilisation par Google des données d'entraînement et des sorties de ses modèles d'IA générative. C'est parce que les images en direct à partir de texte sont actuellement en prévisualisation; la politique ne couvre que les produits d'IA générative en disponibilité générale (GA).

La régurgitation, ou le fait qu'un modèle génératif renvoie une copie miroir d'un exemple (par exemple, une image) sur lequel il a été formé, est légitimement une préoccupation pour les clients entreprises. Des études informelles et académiques ont montré que la première génération d'Imagen n'était pas immunisée contre cela, renvoyant des photos identifiants de personnes, des œuvres protégées par le droit d'auteur d'artistes et plus encore lorsqu'on lui demandait de manière spécifique.

Sauf controverses, problèmes techniques ou d'autres perturbations majeures imprévues, les images en direct à partir de texte seront disponible en GA à un moment donné. Mais avec les images en direct telles qu'elles existent aujourd'hui, Google dit essentiellement : utilisez à vos propres risques.